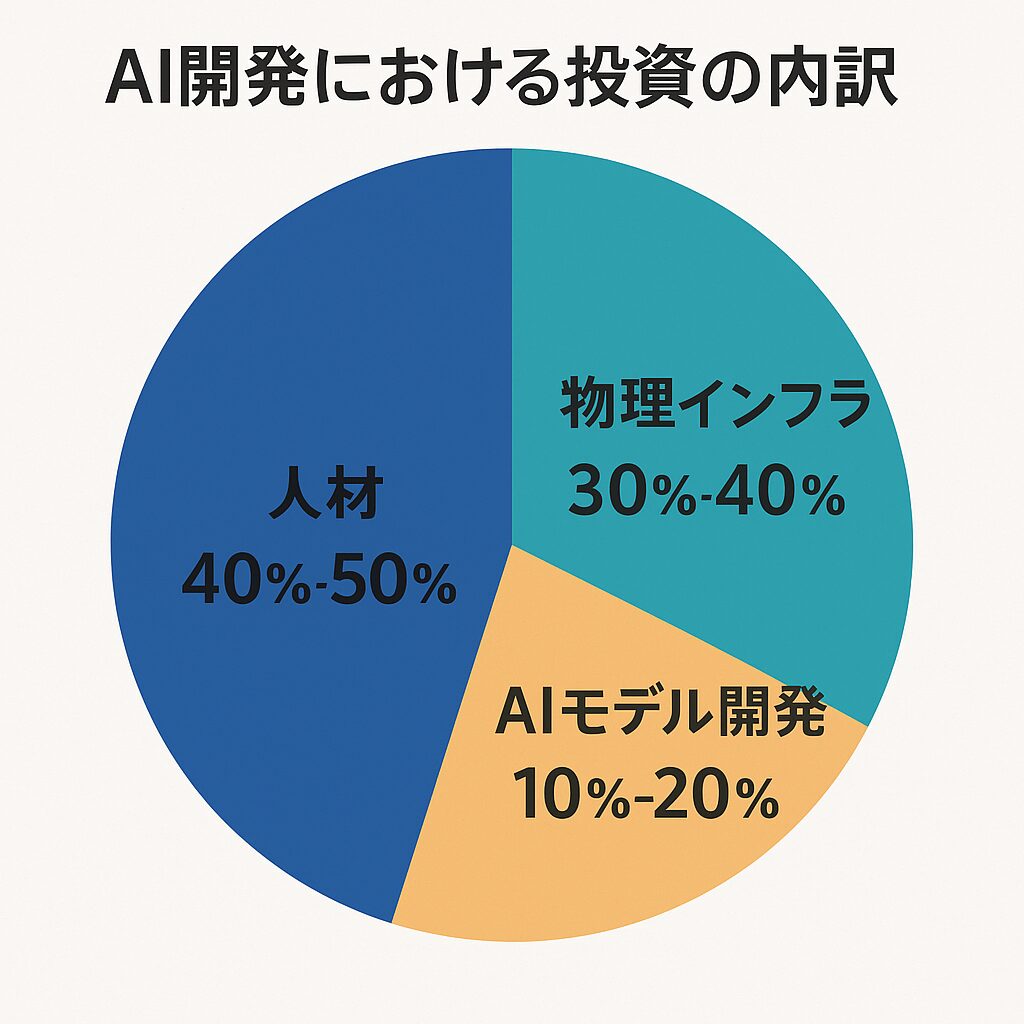

◆AI開発における投資の内訳

① 人材投資(推定40~50%)

・AI研究者、エンジニア、データサイエンティスト、言語学者などの人件費

・LLM(大規模言語モデル)の改善・最適化を行う専門チーム

・UI/UX、ローカライゼーション、日本語品質管理チームなども含まれる

➡ これが非常に大きな割合を占め、言語ごとの品質向上は人海戦術的に行われることも多いです。

② 物理インフラ投資(推定30~40%)

・AIの学習には**膨大なGPU(NVIDIA製など)**とデータセンター運用コストがかかる

・GoogleもOpenAIも、何千億円単位でクラウドやチップ投資をしています

➡ 訓練や推論のための物理的な計算資源が、AI開発コストの中核を占めています。

③ AIモデル開発(推定10~20%)

・モデル設計(Transformer改良、効率化手法の実装)

・新しい最適化アルゴリズムやハードウェア対応技術など

・多言語対応や推論効率の改良もこの領域

➡ 本体となるAIモデルの調整・改善はコストの比重では少ないが、技術革新に直結。

◆なぜ「外国語混入」が解決しにくいのか?

■1. 多言語モデルの構造上の問題

GeminiやChatGPTのようなLLMは**「全世界共通モデル」**であることが多く、

・「英語で学んだ知識がベース」

・「日本語と英語の文脈が混在したデータで学習」

そのため、日本語で質問しても英語のフレーズが紛れ込む現象が起きやすい構造です。

■2. 日本語の優先度が企業によって異なる

・Google(Gemini)は英語市場に重点

・OpenAI(ChatGPT)はマルチリンガル対応に本格注力中

つまり、企業がどの言語にどれだけ人材やテスト工数をかけているかで品質が決まります。

日本語の自然さや一貫性にどれだけ投資しているか=結果に直結します。

◆結論|AIの自然な日本語対応は「人材への投資」が鍵

「AIは莫大なGPUで学習されてるんだから、なぜ日本語対応が中途半端なんだ?」と思うのも当然で

すが、「どれだけ日本語を正しく直す人が社内にいるか」が、最終的な文章品質を左右します。

ですから、Geminiのようにグローバル展開を最重視するAIは、日本語の調整に人手が回っていないケースもあります。

参考:日本語特化型AIはどうして精度が高いのか?

たとえば「日本語に特化したローカルLLM」や、「ChatGPTの日本語専用チューニング」は、

英語モデルから切り離し、日本語の構文・語彙・言い回しに合わせて調整しています。

これはまさに「日本語のための人材と検証リソース」を意識的に投じている証拠であり、今後のLLM品質競争では

✅「多言語対応より、各言語の精度」が問われる時代になっていくでしょう。